NVIDIA Nemotron-Elastic: El nuevo modelo de IA que se entrena una vez y ofrece tres tamaños diferentes

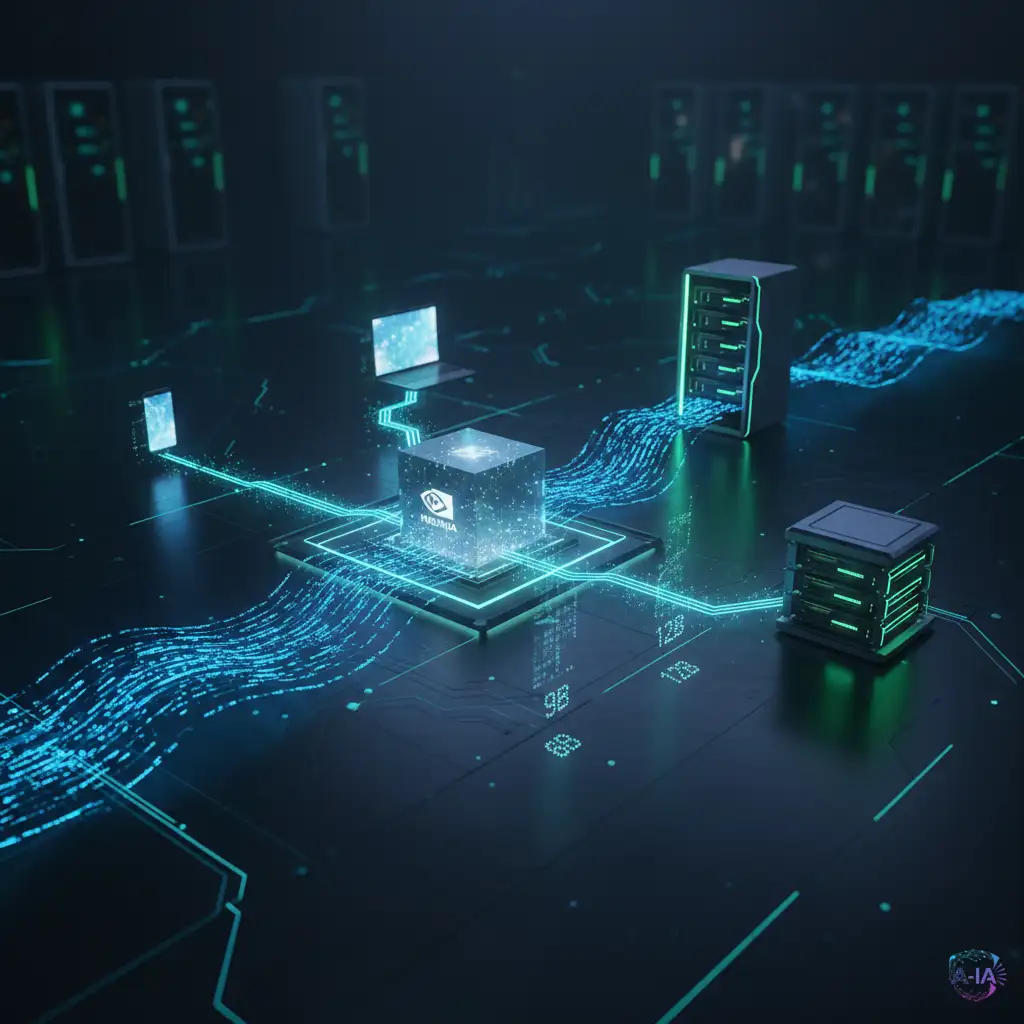

NVIDIA ha lanzado Nemotron-Elastic-12B, un innovador modelo de lenguaje grande que permite generar variantes de 6B, 9B y 12B parámetros a partir de un único proceso de entrenamiento, reduciendo drásticamente los costes y el tiempo de desarrollo para las empresas.

NVIDIA, conocida por ser el motor detrás de la revolución de la Inteligencia Artificial gracias a sus potentes GPUs, no solo fabrica hardware; también desarrolla software y modelos que marcan la pauta en la eficiencia del entrenamiento. Su última novedad es Nemotron-Elastic-12B, y representa un salto importante en cómo se construyen y despliegan los modelos de lenguaje grandes (LLMs).

La innovación clave: Tres modelos por el precio de uno

Tradicionalmente, si una compañía necesita un modelo de IA pequeño (para un móvil) y uno grande (para un servidor), debe entrenar cada uno por separado. Este proceso es extremadamente costoso, requiere mucho tiempo y consume enormes cantidades de energía. Aquí es donde Nemotron-Elastic cambia las reglas del juego.

Nemotron-Elastic-12B es un modelo diseñado con una arquitectura elástica que permite que un único proceso de entrenamiento genere automáticamente tres versiones funcionales con diferentes tamaños de parámetros: 6 mil millones (6B), 9 mil millones (9B) y 12 mil millones (12B). Es como si, en lugar de construir tres coches diferentes en tres líneas de montaje distintas, pudieras construir los tres simultáneamente en la misma línea.

¿Qué hace a este modelo tan especial?

La magia detrás de Nemotron-Elastic reside en su capacidad para "podar" o seleccionar subconjuntos de su red neuronal de forma inteligente durante la fase de entrenamiento. Esto garantiza que las versiones más pequeñas (6B y 9B) mantengan un rendimiento comparable al que tendrían si hubieran sido entrenadas individualmente, evitando la degradación de calidad que a menudo ocurre al simplemente reducir un modelo ya terminado.

El beneficio es doble:

- Ahorro de Costes: Las empresas ahorran miles de horas de cómputo y millones de dólares en costes de entrenamiento, ya que solo pagan por una ejecución en lugar de tres.

- Flexibilidad de Despliegue: Una vez entrenado, el modelo puede ser desplegado en el tamaño más adecuado para la tarea. El modelo de 6B puede ser perfecto para aplicaciones que requieren baja latencia (respuestas rápidas) o para ejecutarse en dispositivos con recursos limitados, mientras que el 12B ofrece la máxima capacidad de razonamiento para tareas complejas en la nube.

La importancia de los diferentes tamaños

En el mundo de la IA, el número de parámetros (B de billones o mil millones) es una medida burda de la complejidad y la capacidad de un modelo. Un modelo de 12B tiene una "memoria" y una capacidad de procesamiento más grandes que uno de 6B, pero también es más lento y requiere hardware más potente para funcionar.

La capacidad de Nemotron-Elastic para ofrecer diferentes puntos de rendimiento y eficiencia en un solo paquete es crucial para la adopción empresarial. Las compañías de software pueden ahora optimizar sus aplicaciones para una amplia gama de usuarios, desde aquellos con los dispositivos más potentes hasta aquellos que dependen de soluciones ligeras.

NVIDIA ha lanzado Nemotron-Elastic-12B bajo una licencia abierta y gratuita, lo que significa que desarrolladores y empresas de todo el mundo pueden empezar a experimentar con esta arquitectura elástica inmediatamente. Este movimiento no solo consolida la posición de NVIDIA como líder en hardware, sino también como un actor clave en la democratización de modelos de IA de alto rendimiento.