La Unión Europea aprueba la Ley de IA: ¿Cómo afectará a tu vida diaria y a las grandes tecnológicas?

La Unión Europea ha finalizado la aprobación de su histórica Ley de IA, la primera regulación integral del mundo, que establece reglas estrictas basadas en el riesgo para los desarrolladores y usuarios de sistemas de inteligencia artificial, protegiendo los derechos fundamentales de los ciudadanos.

La Inteligencia Artificial ha pasado de ser una promesa tecnológica a una realidad cotidiana, y con ella, la necesidad de establecer reglas claras. La Unión Europea (UE) ha dado un paso monumental al aprobar formalmente la Ley de IA (AI Act), convirtiéndose en el primer bloque en el mundo en establecer un marco legal integral para el uso y desarrollo de estos sistemas. Pero, ¿qué significa esto para las empresas que crean IA y para ti, el usuario final?

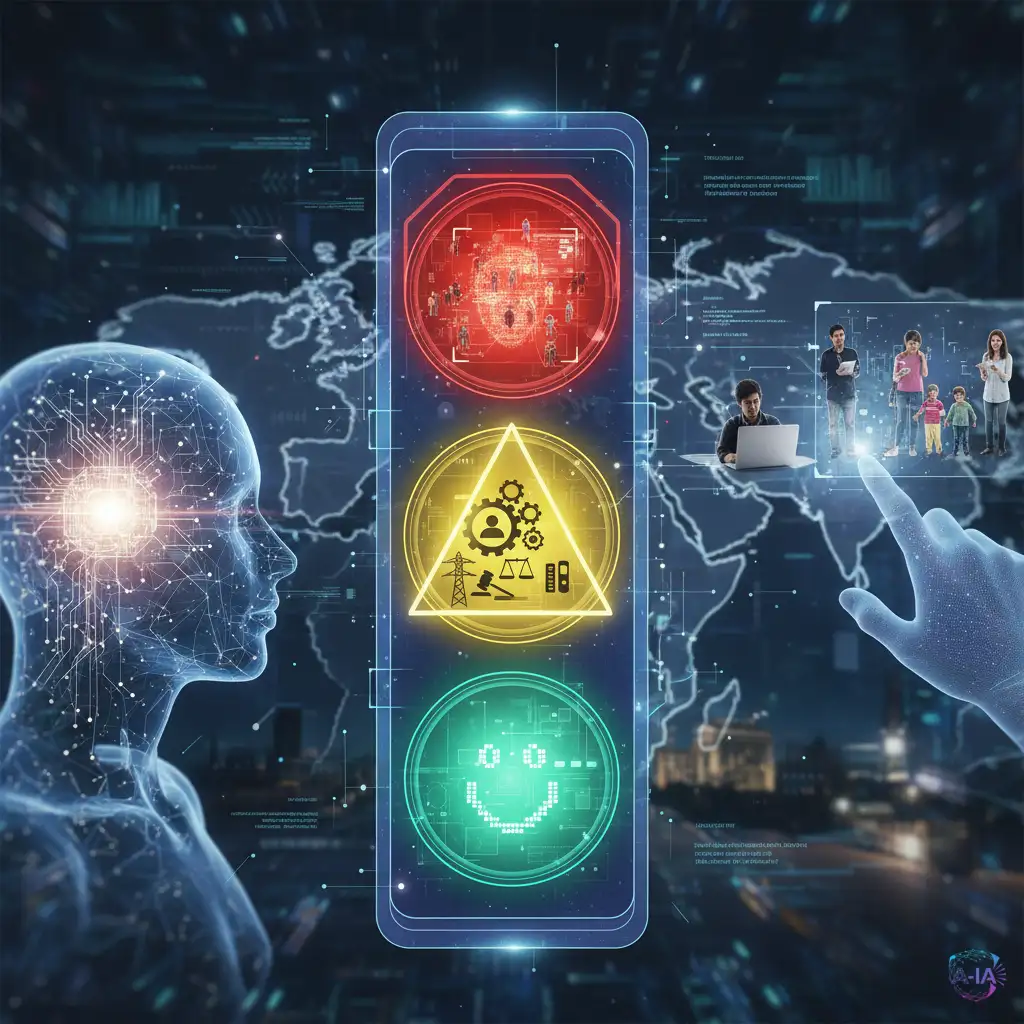

El Sistema de Semáforo: IA Inaceptable, de Alto y Bajo Riesgo

El principio central de la Ley de IA de la UE es su enfoque basado en el riesgo. Imagina un semáforo: dependiendo de cuán peligrosa pueda ser una aplicación de IA, se le aplican diferentes niveles de control. Esto es crucial porque no es lo mismo usar IA para generar imágenes divertidas que usarla para decidir si alguien recibe un préstamo o es contratado.

Riesgo Inaceptable (Luz Roja): Estos sistemas están directamente prohibidos porque violan los valores fundamentales de la UE. Esto incluye el uso de la IA para el llamado "social scoring" (clasificar a las personas según su comportamiento social, como se ha visto en algunos países) y ciertas técnicas de reconocimiento de emociones en el lugar de trabajo o en escuelas.

Alto Riesgo (Luz Amarilla): Aquí es donde se encuentran los sistemas más críticos, como la IA utilizada en infraestructuras esenciales (agua, electricidad), en la toma de decisiones legales, en la gestión de recursos humanos o en dispositivos médicos. Los desarrolladores de estos sistemas tendrán que pasar por evaluaciones de conformidad rigurosas antes de poder lanzarlos al mercado. Deberán garantizar transparencia, supervisión humana y precisión de los datos.

Riesgo Limitado o Mínimo (Luz Verde): La mayoría de las aplicaciones de consumo, como los chatbots o los filtros de spam, caen en esta categoría. Las reglas son mucho más flexibles, aunque aún se exige cierta transparencia, como informar a los usuarios cuando están interactuando con una IA (por ejemplo, con un chatbot).

¿Cómo Afecta a Gigantes como Google u OpenAI?

La Ley de IA no solo se centra en aplicaciones específicas, sino también en los Modelos Fundacionales (Foundation Models), que son los grandes cerebros de IA generativa detrás de herramientas como ChatGPT o Gemini. Estos modelos deben cumplir con requisitos de transparencia significativos, especialmente en lo que respecta a la documentación técnica y la gestión de riesgos.

Para las grandes tecnológicas que operan a nivel global, la Ley de IA de la UE impone lo que se conoce como el "Efecto Bruselas". Esto significa que, para poder operar en el lucrativo mercado europeo, las empresas tendrán que adaptar sus productos y estándares a las regulaciones más estrictas del mundo. Es probable que, en lugar de crear dos versiones de un producto, simplemente adopten los altos estándares de la UE a nivel mundial.

Un Equilibrio entre Innovación y Seguridad

El objetivo de la Comisión Europea no es frenar la innovación, sino asegurar que la IA se desarrolle y use de una manera que respete los derechos humanos y la seguridad. Al establecer límites claros y responsabilidades definidas, se busca generar confianza pública en la tecnología.

Si bien la implementación total de la ley tomará tiempo (muchas disposiciones entrarán en vigor progresivamente hasta 2026), el mensaje es claro: la era del desarrollo de IA sin restricciones ha terminado en Europa. Ahora, la ética y la responsabilidad legal serán tan importantes como la capacidad de procesamiento del modelo.