Google intensifica la lucha contra las estafas de IA en India, pero los vacíos de seguridad persisten

Google está implementando medidas avanzadas en India para proteger a los usuarios de estafas digitales hiperrealistas potenciadas por la Inteligencia Artificial, como los deepfakes y la clonación de voz, aunque reconoce que la rápida evolución del fraude deja desafíos significativos.

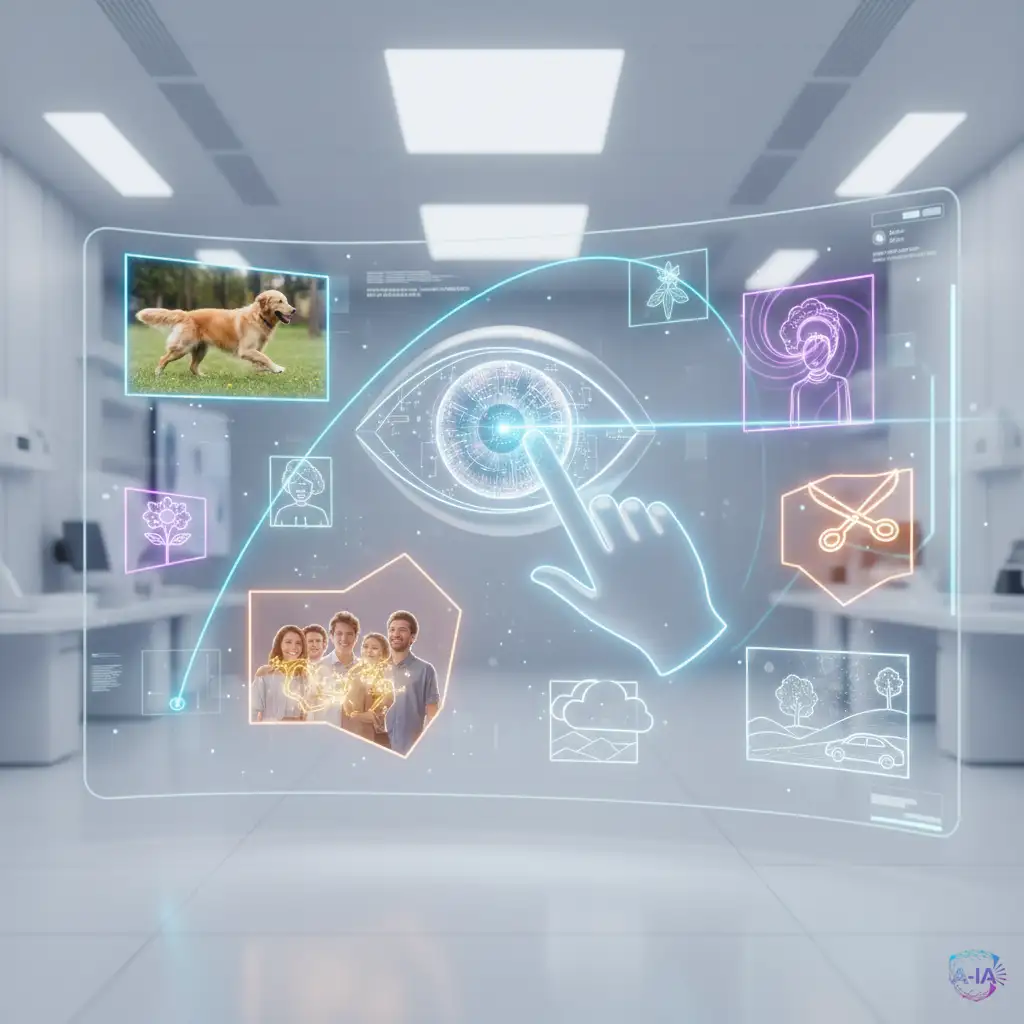

La Inteligencia Artificial no solo está creando nuevas herramientas de productividad, sino que también está armando a los ciberdelincuentes con capacidades sin precedentes. Las estafas digitales han pasado de ser correos mal escritos a ser llamadas telefónicas con la voz clonada de un familiar o videos deepfake convincentes.

El Campo de Batalla: India y la Necesidad de Defensa

India, con su enorme base de usuarios de internet y su rápida digitalización, se ha convertido en un punto focal para las estafas en línea. Google ha reconocido que la sofisticación de los fraudes impulsados por IA exige una respuesta de seguridad igualmente avanzada. Las medidas se centran en fortalecer las plataformas clave donde ocurren estas interacciones, como Google Pay, Gmail y, crucialmente, la búsqueda.

El objetivo de Google es doble: por un lado, detectar y bloquear contenido fraudulento antes de que llegue al usuario; por otro, educar a los usuarios para que reconozcan las señales de alerta de las estafas potenciadas por IA.

¿Qué hace a las Estafas de IA tan Peligrosas?

La principal amenaza reside en el hiperrealismo. Antes, una estafa telefónica dependía de un actor o una grabación genérica. Hoy, un estafador puede usar un modelo de clonación de voz para imitar perfectamente la voz de un CEO, un hijo o un amigo, haciendo que el engaño sea casi imposible de distinguir de la realidad.

Esto se logra mediante modelos generativos de IA que analizan pequeñas muestras de audio o video y crean contenido completamente nuevo que parece auténtico. Los ejemplos más comunes incluyen:

- Deepfakes de video: Utilizados para extorsión o para suplantar la identidad en videollamadas.

- Clonación de voz: Usada para llamadas de emergencia falsas o para autorizar transferencias bancarias fraudulentas.

La velocidad a la que estos modelos pueden generar contenido malicioso supera con creces la capacidad de las herramientas de detección tradicionales.

Los Desafíos Pendientes de la Seguridad Digital

Aunque Google está invirtiendo fuertemente en herramientas de detección de anomalías y en la verificación de identidad, la empresa reconoce que el panorama de amenazas sigue evolucionando más rápido que las soluciones. El problema principal es la naturaleza adaptativa de la IA maliciosa.

Los ciberdelincuentes ajustan constantemente sus modelos para evadir los filtros de seguridad. Esto crea una carrera armamentística digital donde la protección debe ser proactiva, no solo reactiva. Los "vacíos" que persisten se deben a varios factores:

- Modelos de IA de código abierto: La disponibilidad de herramientas potentes permite a cualquiera crear deepfakes de alta calidad.

- Escala del problema: Millones de interacciones diarias hacen que sea imposible revisar manualmente cada contenido sospechoso.

- Falta de regulación global: La ausencia de leyes claras sobre el uso de la identidad digital en la era de la IA complica la persecución de los delincuentes.

La estrategia de Google en India sirve como un laboratorio crucial para probar estas defensas. Si logran contener eficazmente las estafas de IA en un mercado tan grande y dinámico, esas soluciones podrán implementarse globalmente, marcando un paso adelante en la protección de la identidad digital de todos los usuarios.