El motor oculto de la IA: Cómo Apache Spark y PySpark gestionan los datos masivos para entrenar modelos

Apache Spark y PySpark son herramientas esenciales de ingeniería de datos que permiten a las empresas manejar y procesar petabytes de información, un paso crucial para el entrenamiento eficiente y escalable de los modelos de Machine Learning más avanzados.

La Inteligencia Artificial moderna, especialmente los grandes modelos de lenguaje (LLMs) como GPT-4, no son solo algoritmos complejos; son devoradores insaciables de datos. Para que estos modelos funcionen de manera efectiva y escalable, las empresas necesitan una infraestructura robusta capaz de manejar petabytes de información. Aquí es donde entran en juego herramientas de ingeniería de datos como Apache Spark y PySpark, el motor oculto que asegura que el ‘combustible’ (los datos) llegue limpio y a tiempo al motor (el modelo de IA).

¿Qué es un “Pipeline” y por qué lo necesita la IA?

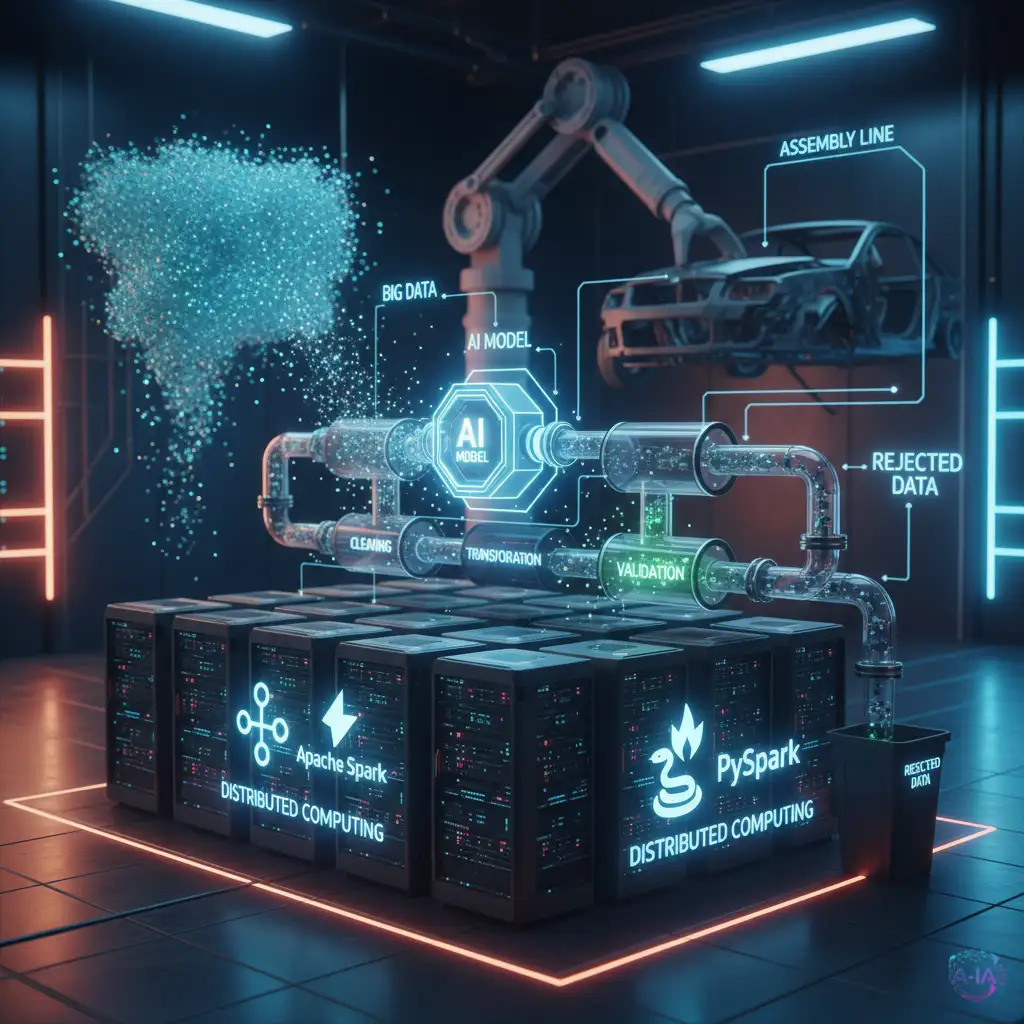

Imagina que estás construyendo un coche. No puedes simplemente arrojar todas las piezas a la vez y esperar que funcione. Necesitas una línea de ensamblaje bien organizada. En el mundo de la IA, esa línea de ensamblaje se llama pipeline (o tubería) de Machine Learning.

Un pipeline es una serie de pasos automatizados que transforman los datos brutos en algo útil para el modelo. Esto incluye limpieza, transformación, validación y, finalmente, el entrenamiento del modelo. Si el pipeline falla, el modelo recibe datos sucios o incompletos, lo que resulta en una IA lenta, inexacta o sesgada.

La clave del éxito en la IA a gran escala es que este proceso debe ser increíblemente rápido y capaz de manejar volúmenes de datos que superan la capacidad de cualquier ordenador individual. Aquí es donde la computación distribuida se vuelve indispensable.

Apache Spark: El gigante que domina los datos

Apache Spark es un framework de procesamiento de datos diseñado para manejar tareas de Big Data de manera paralela y distribuida. En lugar de procesar un archivo enorme en una sola máquina, Spark lo divide en miles de fragmentos y los procesa simultáneamente en un cluster de ordenadores. Esto es lo que le permite procesar datos a velocidades asombrosas.

Para el entrenamiento de la IA, Spark es vital porque permite:

- Preparación masiva de datos: Limpiar y estandarizar terabytes de texto o imágenes en minutos, no en días.

- Ingesta continua: Alimentar modelos con nuevos datos en tiempo real, esencial para sistemas que aprenden constantemente.

- Escalabilidad: A medida que crecen los datos de entrenamiento, simplemente se añaden más nodos al cluster de Spark para mantener el rendimiento.

PySpark: Python se une a la fiesta de la velocidad

Si Apache Spark es el motor de alto rendimiento, PySpark es el lenguaje que permite a los científicos de datos y desarrolladores controlarlo. PySpark es la API de Python para Spark. Combina la velocidad y la eficiencia de Spark con la facilidad de uso y la vasta biblioteca de herramientas de Python (como Pandas y Scikit-learn).

Esta combinación es fundamental. Los científicos de datos prefieren Python por su flexibilidad y su ecosistema centrado en el Machine Learning. Gracias a PySpark, pueden escribir código familiar en Python para diseñar algoritmos de entrenamiento complejos, mientras que Spark se encarga silenciosamente de la pesada tarea de distribuir la carga de trabajo entre cientos de máquinas.

La infraestructura que define el futuro de la IA

La capacidad de construir pipelines de datos robustos y escalables con herramientas como Apache Spark es lo que separa a las empresas que pueden crear y mantener modelos de IA de vanguardia de aquellas que se quedan atrás. No basta con tener el mejor algoritmo; si la infraestructura de datos no puede mantener el ritmo, el modelo nunca alcanzará su máximo potencial.

En la era de los modelos multimodales y los LLMs que requieren cantidades de datos sin precedentes, dominar la ingeniería de datos con Apache Spark no es solo una habilidad técnica valiosa, sino una necesidad estratégica que impulsa el avance real de la Inteligencia Artificial.