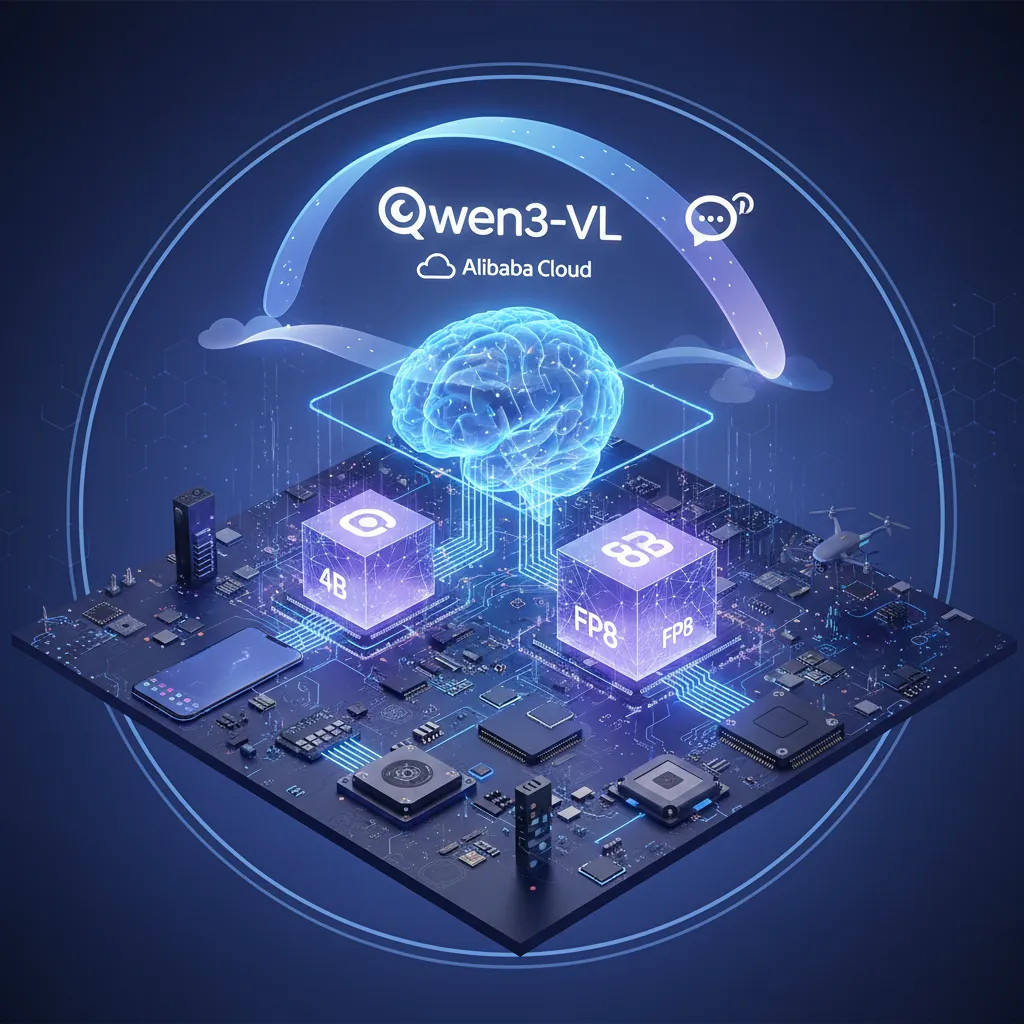

Alibaba Lanza Qwen3-VL: Modelos Multimodales Compactos de 4B y 8B Optimizados con FP8

Alibaba Cloud ha presentado Qwen3-VL, una nueva serie de modelos multimodales de lenguaje (LLMs) compactos en versiones de 4B y 8B, optimizados con cuantificación FP8. Estos modelos ofrecen capacidades avanzadas de visión y lenguaje, prometiendo inferencia eficiente para dispositivos edge y aplicaciones con recursos limitados.

La carrera por desarrollar modelos de inteligencia artificial más potentes y eficientes continúa, y Alibaba Cloud se posiciona firmemente con el lanzamiento de su última innovación: Qwen3-VL. Esta nueva serie de modelos multimodales de lenguaje (LLMs) se presenta en variantes compactas de 4 mil millones (4B) y 8 mil millones (8B) de parámetros, destacando por su optimización con puntos de coma flotante de 8 bits (FP8), lo que abre nuevas puertas para la inferencia en entornos con recursos limitados.

Presentando Qwen3-VL: Visión y Lenguaje en Formato Compacto

Qwen3-VL representa un avance significativo en la democratización de la IA, al ofrecer modelos multimodales robustos en un tamaño reducido. La designación 'VL' subraya su capacidad para procesar y entender no solo texto, sino también información visual, lo que los hace ideales para una amplia gama de aplicaciones que requieren una comprensión contextual profunda del mundo real. Las versiones de 4B y 8B están diseñadas para ser ágiles, permitiendo a los desarrolladores integrarlas en dispositivos edge, aplicaciones móviles y sistemas embebidos donde el espacio de memoria y la potencia de cómputo son críticos. Esta compactación no sacrifica la calidad, sino que busca un equilibrio óptimo entre rendimiento y eficiencia.

La Innovación de FP8: Eficiencia y Rendimiento

Uno de los pilares de la eficiencia de Qwen3-VL es la implementación de la cuantificación FP8. Esta técnica reduce la precisión de los cálculos de 16 o 32 bits a solo 8 bits, lo que tiene un impacto directo en la reducción del consumo de memoria y la aceleración de la inferencia. Para los desarrolladores, esto significa la posibilidad de ejecutar modelos complejos en hardware menos potente y más asequible, disminuyendo los costes operativos y la latencia. La adopción de FP8 es una tendencia creciente en la industria, y Alibaba se suma a esta vanguardia, demostrando su compromiso con la optimización del rendimiento de la IA en el mundo real. La eficiencia energética resultante también es un factor crucial para la sostenibilidad y el despliegue a gran escala de la IA.

Modos "Instruct" y "Thinking": Versatilidad para Desarrolladores

Alibaba ha dotado a Qwen3-VL de dos modos operativos distintos: Instruct y Thinking. La versión Instruct está diseñada para seguir instrucciones directas y concisas, lo que la hace perfecta para tareas específicas como la generación de texto basado en comandos, la respuesta a preguntas o la automatización de flujos de trabajo. Por otro lado, la versión Thinking está optimizada para tareas que requieren un razonamiento más complejo y una comprensión contextual más profunda, como el análisis de escenarios, la resolución de problemas o la generación de contenido creativo que implica un proceso de pensamiento. Esta dualidad ofrece una flexibilidad considerable a los desarrolladores, permitiéndoles elegir el modelo más adecuado para la complejidad y la naturaleza de la tarea a realizar, maximizando así la eficiencia y la precisión de sus aplicaciones.

Implicaciones y Futuro de los LLMs Compactos

El lanzamiento de Qwen3-VL subraya una tendencia clara en el ecosistema de la IA: la búsqueda de modelos más pequeños, más rápidos y más eficientes. Estos modelos compactos son esenciales para llevar la inteligencia artificial avanzada más allá de los centros de datos, hacia el edge computing, la robótica, los vehículos autónomos y la Internet de las Cosas (IoT). La capacidad de ejecutar modelos multimodales directamente en dispositivos sin una conexión constante a la nube no solo mejora la privacidad y la seguridad, sino que también reduce la latencia, lo cual es crítico para aplicaciones en tiempo real. Alibaba Cloud, con su experiencia en infraestructura y desarrollo de IA, está posicionándose como un actor clave en esta evolución, compitiendo con otros gigantes tecnológicos que también invierten en modelos de lenguaje eficientes. La accesibilidad de estos modelos compactos tiene el potencial de democratizar aún más el desarrollo de la IA, permitiendo a una gama más amplia de innovadores crear soluciones disruptivas.

En resumen, Qwen3-VL de Alibaba Cloud es un testimonio del progreso en la optimización de modelos de IA. Al combinar capacidades multimodales con una eficiencia sin precedentes gracias a la cuantificación FP8 y ofrecer variantes adaptadas a distintas necesidades de razonamiento, Alibaba no solo mejora el rendimiento de la IA, sino que también amplía significativamente su alcance y aplicabilidad en el mundo real. Este lanzamiento marca un paso importante hacia un futuro donde la inteligencia artificial avanzada es más accesible y omnipresente.