LongCat-Flash-Omni: El modelo de IA de código abierto que entiende audio y vídeo en tiempo real

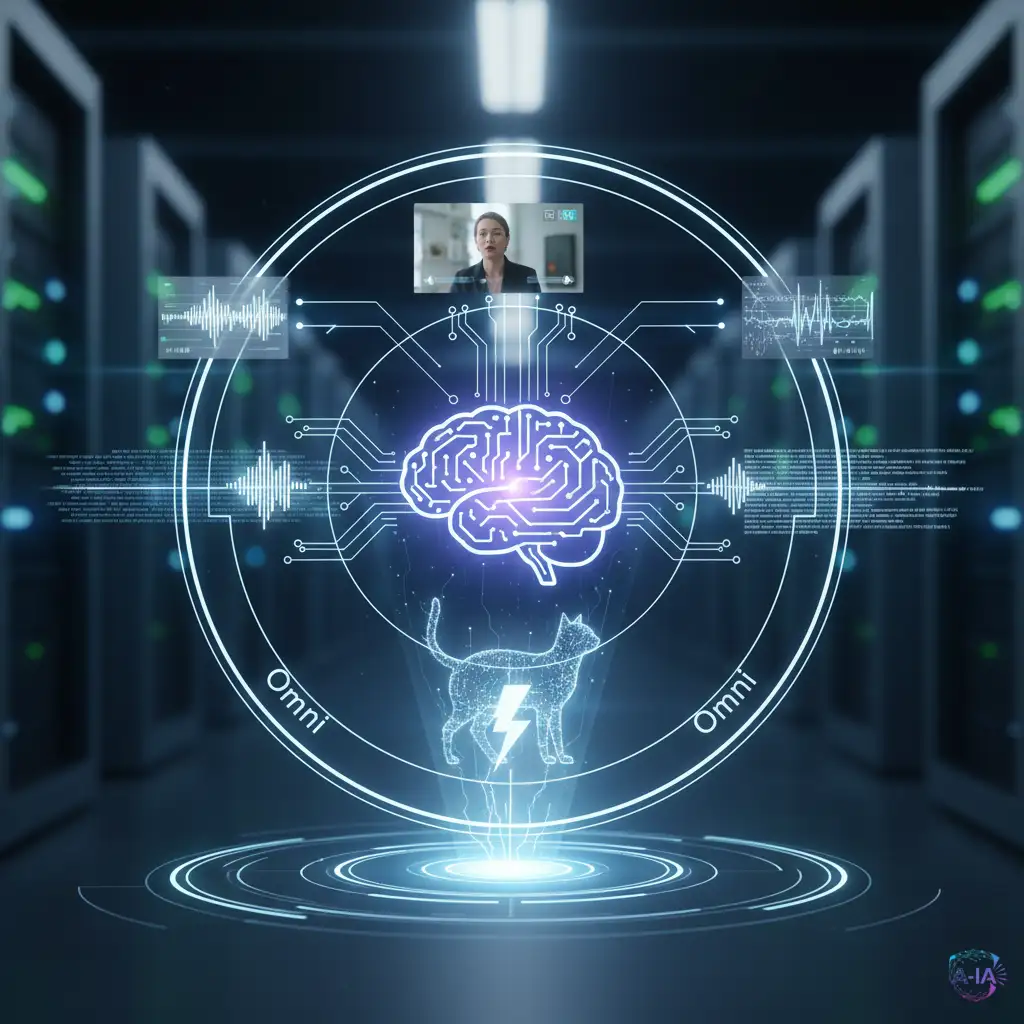

Investigadores han lanzado LongCat-Flash-Omni (LFO), un modelo omnimodal de 560 mil millones de parámetros que destaca por su capacidad para procesar e interactuar con información de audio y vídeo en tiempo real, ofreciendo un rendimiento de vanguardia bajo una licencia de código abierto.

La próxima generación de Inteligencia Artificial no solo leerá texto o verá imágenes; las IAs deberán ser capaces de entender el mundo tal como lo hacemos nosotros: usando múltiples sentidos a la vez y reaccionando al instante. Aquí es donde entra LongCat-Flash-Omni (LFO), un nuevo modelo de lenguaje grande (LLM) que está redefiniendo los límites de la interacción audiovisual.

LFO no es solo otro modelo grande. Es una proeza de ingeniería que combina una vasta capacidad de conocimiento (560 mil millones de parámetros) con una eficiencia sorprendente, logrando un rendimiento de vanguardia (SOTA) en tareas que requieren comprender y responder a estímulos de audio y vídeo simultáneamente y sin demoras.

¿Qué significa ser un modelo "Omni-Modal"?

La mayoría de las IAs actuales son unimodales (solo texto, como los primeros GPT) o multimodales (manejan texto e imágenes, como GPT-4o). Un modelo omnimodal va un paso más allá, integrando fluidamente múltiples tipos de datos sensoriales, como el audio, el vídeo y el texto, y procesándolos como un todo unificado.

Piensa en LFO como si tuviera los ojos y los oídos de un humano conectados a un cerebro artificial. Puede ver una persona hablando, escuchar lo que dice, leer los labios y entender el contexto emocional de la voz, todo al mismo tiempo. Esta capacidad es crucial para aplicaciones avanzadas como asistentes virtuales que realmente puedan participar en conversaciones complejas o sistemas de seguridad que interpreten eventos en tiempo real.

La clave de la velocidad: Arquitectura de expertos dispersos

Uno de los aspectos más impresionantes de LongCat-Flash-Omni es su tamaño total de 560 mil millones de parámetros, pero con solo 27 mil millones de parámetros activados en cualquier momento. Esta es la magia de la arquitectura conocida como MoE (Mixture of Experts o Mezcla de Expertos).

En lugar de usar todo el cerebro para cada tarea, la arquitectura MoE permite que el modelo active solo las partes más relevantes (los 'expertos') para la consulta específica. Esto permite que LFO mantenga una velocidad de procesamiento crítica para la interacción en tiempo real, mientras sigue teniendo acceso a una base de conocimiento gigantesca. Es como tener un equipo de 560 expertos en una sala, pero solo llamar al especialista de 27 para resolver el problema exacto que tienes, optimizando el tiempo y los recursos.

El impacto del código abierto en la investigación

El hecho de que LongCat-Flash-Omni sea un modelo de código abierto es quizás su característica más transformadora para el ecosistema de la IA. Al liberar el modelo y sus pesos, los desarrolladores, investigadores y startups de todo el mundo pueden:

- Inspeccionar y auditar cómo funciona el modelo, mejorando la transparencia.

- Ajustar y personalizar el modelo para tareas específicas (fine-tuning) sin depender de grandes corporaciones.

- Acelerar la innovación, ya que no tienen que empezar desde cero para construir sistemas omnimodales avanzados.

Esta democratización del acceso a modelos de vanguardia reduce la barrera de entrada y fomenta una competencia más sana y rápida en el desarrollo de aplicaciones de IA de próxima generación.

Un vistazo al futuro de la interacción

La llegada de modelos como LFO nos acerca a interfaces de IA verdaderamente naturales. Imagina un futuro donde tu asistente virtual no solo te diga qué hay en la nevera, sino que observe tu expresión facial y el tono de tu voz para sugerir una receta que se adapte a tu estado de ánimo. O sistemas de robótica que no solo navegan por un espacio, sino que entienden las señales sociales y sonoras de las personas a su alrededor.

LongCat-Flash-Omni marca un hito importante, demostrando que la complejidad y la velocidad pueden coexistir, y que la comunidad de código abierto sigue siendo una fuerza motriz esencial en el avance de la Inteligencia Artificial.